Lügende Computer

Wir leben gerade in einem kritischen Übergangs-Zeitalter zwischen Computern, auf die man sich halbwegs verlassen kann und den neuen “AI”-Systemen, die driften, halluzinieren, lügen und fabulieren können. Schon heute ist die Komplexität moderner Softwaresysteme so hoch, dass es kühn wäre, von striktem Determinismus zu sprechen, jedoch sind auch komplexe Algorithmen darauf angelegt, bei gleichen Eingabedaten gleiche Ergebnisse zu produzieren. Eine Ausnahme sind heute schon Algorithmen, die Zufallszahlen als Teil ihrer Eingabeparameter (Öffnet in neuem Fenster)beinhalten oder neuronale Netze.

Mit neuronalen Netzen und ihren Weiterentwicklungen, wie Large Language Models (LLMs) und anderer “generativer AI”, sind die Ergebnisse nicht mehr wirklich rückrechenbar. Nachzuvollziehen, wie ein bestimmtes Ergebnis zustandekam, wird praktisch unmöglich. Prinzipiell ist das erstmal kein Problem, solange das Ergebnis “korrekt” im Sinne der Intentionen und Optimierungskriterien ist, für die das System trainiert wurde. Die aktuellen Diskussionen um in Trainingsdaten von ChatGPT und ähnlichen Systemen enthaltenen Vorurteile und Tendenzen sind aber erst der Anfang eines wilden Rittes.

Generative AI hat ihren Ursprung in einem Experiment namens Deep Dream (Öffnet in neuem Fenster). Grob vereinfacht wird dazu ein auf Bilddaten trainiertes neuronales Netz mit Rauschen gefüttert, das darin versucht Bilder aus den Trainingsdaten zu finden, diese einzufügen und die Ausgabe rekursiv wieder in den Eingang gefüttert und dann an Parametern gedreht, bis ein neues entsteht. Man kann sich das so vorstellen, wie so lange auf eine Raufasertapete zu starren, während einem Stichworte ins Ohr geflüstert werden, bis man Muster und Bilder sieht, die dann irgendwas mit den Stichworten zu tun haben.

Generative AI halluziniert also erstmal als Grundfunktion, die Stichworte sind die Prompts. Dass die Ausgaben immer besser verwendbar werden, ist verschiedenen Tricks zu verdanken, die die Parameter beeinflussen. Bei textbasierten Systemen wie ChatGPT ist der wichtigste Trick ein statistisches Modell, das ermittelt, welches Wort das wahrscheinlichste nächste Wort im Satz sein sollte. Dank extrem großer Mengen Trainingsdaten (im wesentlichen das halbe Internet), sind die Ausgaben inzwischen erstaunlich brauchbar. Die Frage ist nun, wofür wir die Systeme verwenden. Ich habe ChatGPT mal befragt (Ausgaben im weiteren Verlauf kursiv gesetzt):

Für welche Aufgaben sollte Chatgpt nicht verwendet werden, weil die Gefahr von Halluzination besteht?

Es gibt einige Aufgaben, bei denen die Verwendung von ChatGPT und anderen Large Language Models aufgrund des Risikos von Halluzinationen und unangemessenen Ausgaben vermieden werden sollte. Hier sind einige Beispiele:

Entscheidungsfindung und -bewertung: ChatGPT sollte nicht für die Entscheidungsfindung oder -bewertung verwendet werden, da es aufgrund von Halluzinationen und unvorhergesehenen Ausgaben zu falschen oder unangemessenen Entscheidungen kommen kann.

Medizinische Diagnose und Behandlung: ChatGPT sollte nicht für medizinische Diagnose und Behandlung verwendet werden, da es möglicherweise nicht in der Lage ist, genaue medizinische Diagnosen zu stellen und angemessene Behandlungsoptionen zu empfehlen.

Rechtliche Beratung: ChatGPT sollte nicht für rechtliche Beratung verwendet werden, da es möglicherweise nicht in der Lage ist, genaue und angemessene juristische Ratschläge zu geben, was zu rechtlichen Problemen führen könnte.

Politische Entscheidungsfindung: ChatGPT sollte nicht für politische Entscheidungsfindung verwendet werden, da es möglicherweise politische Ansichten oder Vorschläge generiert, die unrealistisch oder unangemessen sind.

Finanzberatung: ChatGPT sollte nicht für Finanzberatung verwendet werden, da es möglicherweise nicht in der Lage ist, genaue finanzielle Empfehlungen zu geben, die auf individuellen Bedürfnissen und Zielen basieren.

Psychologische Beratung: ChatGPT sollte nicht für psychologische Beratung oder Diagnose verwendet werden, da es möglicherweise nicht in der Lage ist, genaue und angemessene psychologische Ratschläge zu geben und möglicherweise die Symptome von psychischen Störungen falsch interpretiert.

Technische Entwicklung: ChatGPT sollte nicht für die technische Entwicklung oder Programmierung verwendet werden, da es möglicherweise nicht in der Lage ist, angemessene und fehlerfreie Codevorschläge zu generieren.

Sicherheits- oder Verteidigungsanwendungen: ChatGPT sollte nicht für Sicherheits- oder Verteidigungsanwendungen verwendet werden, da es möglicherweise fehlerhafte und gefährliche Vorschläge generiert, die eine Bedrohung für die Sicherheit darstellen können.

Lehr- und Bildungsanwendungen: ChatGPT sollte nicht als primäres Lehrmittel oder zur Beantwortung von Prüfungsfragen verwendet werden, da es möglicherweise nicht in der Lage ist, korrekte und vollständige Antworten zu geben.

Wissenschaftliche Forschung: ChatGPT sollte nicht als primäre Forschungsquelle in wissenschaftlichen Studien verwendet werden, da es möglicherweise unangemessene oder fehlerhafte Ergebnisse generiert.

Übersetzungsdienste: ChatGPT sollte nicht als alleiniger Übersetzungsdienst verwendet werden, da es möglicherweise nicht in der Lage ist, genaue und präzise Übersetzungen zu generieren.

Kreativitätsanwendungen: ChatGPT sollte nicht als alleiniger kreativer Partner verwendet werden, da es möglicherweise nicht in der Lage ist, ein tiefes Verständnis von künstlerischen oder kreativen Konzepten zu entwickeln und möglicherweise nur oberflächliche Vorschläge generiert.

Dummerweise fallen mir für jeden dieser Punkte mindestens zwei Startups ein, die genau das versuchen. Die Liste ist natürlich nicht erschöpfend. Jeder Bereich, in dem Menschen mit profitorientierten Unternehmen kommunizieren, Behörden und Institutionen versuchen ihre Arbeitsbelastung zu reduzieren oder auch Software zu schreiben, wird in den nächsten Monaten und Jahren mit generativer AI geflutet werden. Das Problem ist, dass Systeme wie ChatGPT nicht wirklich “verstehen”, sie können nur aufgrund der oben beschriebenen Mechanismen elegant und überzeugend so tun, als würden sie irgendwie ein Weltverständnis entwickelt haben.

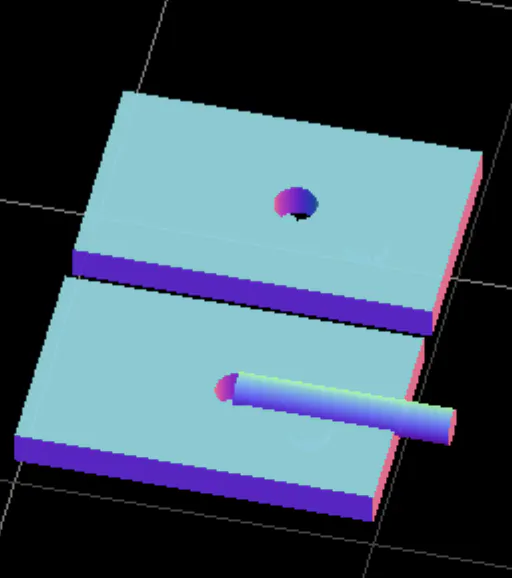

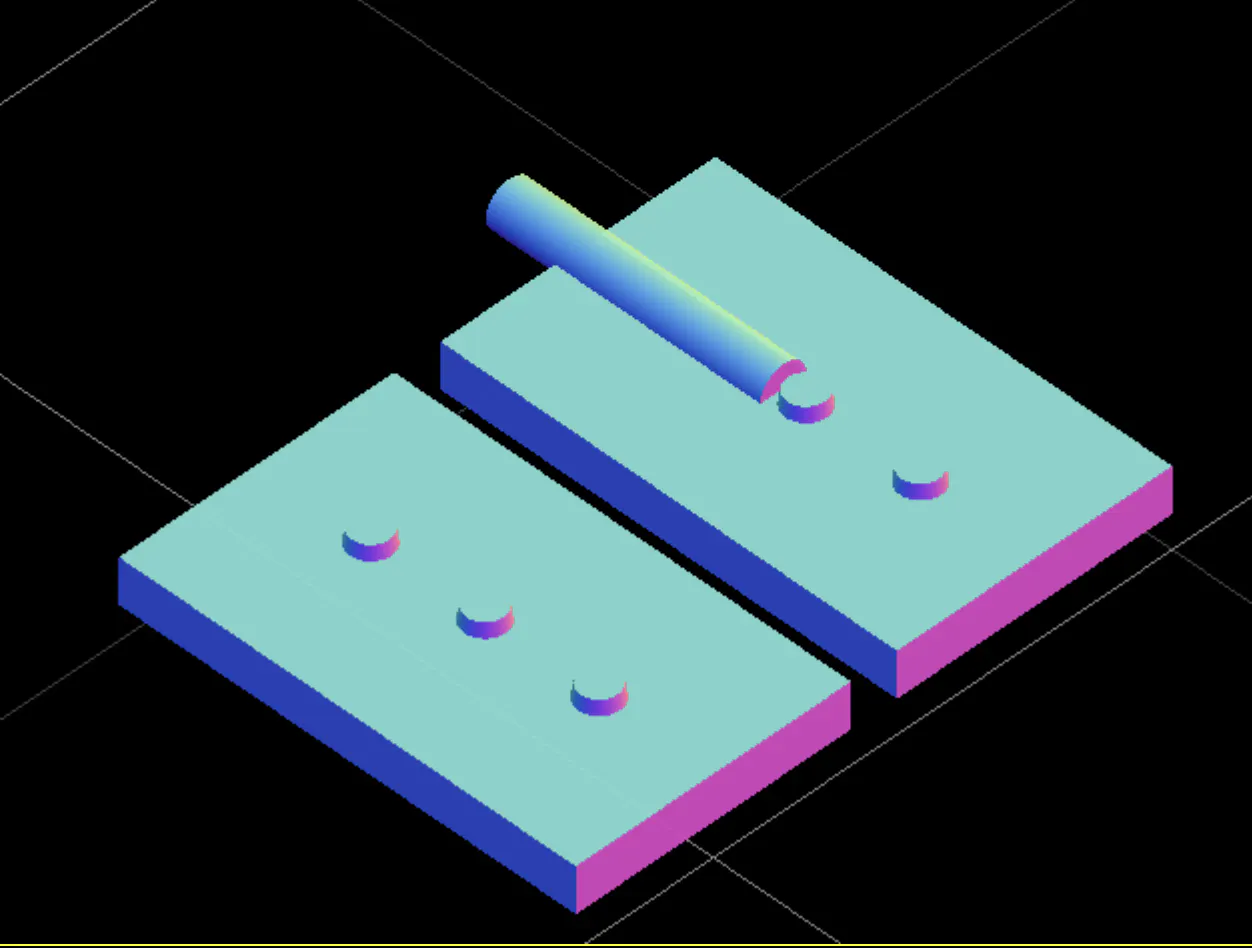

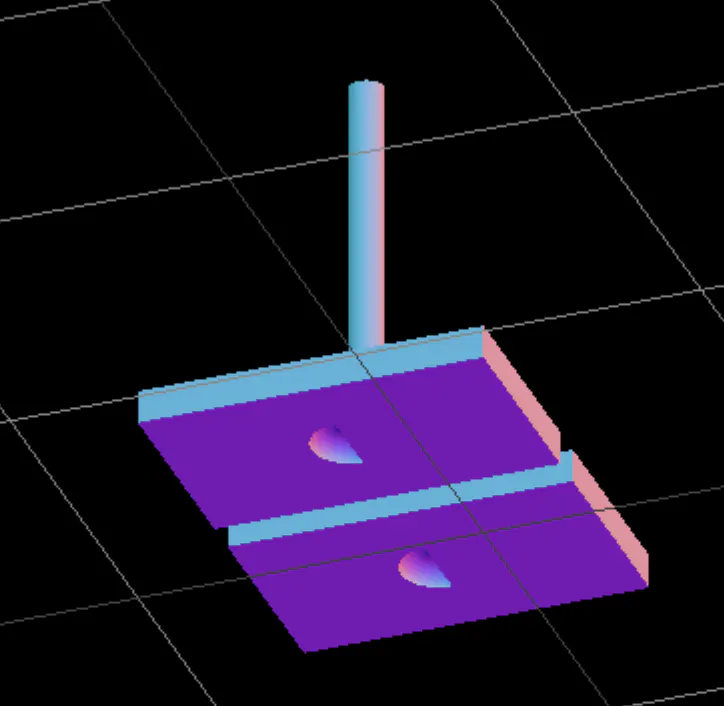

Um das Problem etwas zu illustrieren habe ich ChatGPT-4, dem aktuellsten System, die Aufgabe gestellt, ein einfaches CAD-Modell eines Scharniers zu erstellen, mit einer detailierten Beschreibung wie so ein Scharnier aussieht und wiederholter Aufforderung zur Korrektur mit Angabe, was nicht korrekt ist. Das Ergebnis zeigt ist einerseits beeindruckend – der erzeugte parametrische OpenSCAD-Code compiled und erzeugt valide Objekte – und andererseits eher belustigend:

Es kristallisierte sich heraus, dass das “Verständnis” davon, was ein Scharnier ist, irgendwie falsch ist. Also habe ich um eine Beschreibung eines Scharniers gebeten. Das Ergebnis gibt schon einen Hinweis darauf, was schiefläuft:

"At the center of each flange, there is a semicircular cutout, forming a loop or knuckle when the two flanges are aligned together. The hinge pin, which is a cylindrical rod, passes through the aligned loops, creating a pivot point around which the flanges can rotate."

Aufgefordert ein CAD-Modell entsprechend der textuellen Beschreibung (also ohne weitere Parameter) zu generieren kommt dieses Ergebnis:

Es wird unmittelbar klar, was das Problem ist: Die Interpretation von “center” ist durchaus valide, aber inhaltlich völlig falsch. Das Problem ist ChatGPT durchaus “bewusst”:

Können Worte mit mehreren Bedeutungen zu Drift in LLMs führen?

Ja, Wörter mit mehreren Bedeutungen können tatsächlich zu Drift in LLMs führen. Wenn ein Wort mehrere Bedeutungen hat, muss das Modell in der Lage sein, den Kontext zu verstehen, um zu entscheiden, welche Bedeutung am besten zur aktuellen Situation passt. Wenn das Modell nicht in der Lage ist, den Kontext korrekt zu interpretieren, kann es zu einer unerwarteten Bedeutung des Wortes führen, die möglicherweise nicht im Kontext der Eingabe steht.

Ein Beispiel hierfür ist das Wort "Bank", das je nach Kontext unterschiedliche Bedeutungen haben kann. Es kann eine Bank als Finanzinstitut oder als Sitzgelegenheit gemeint sein. Wenn das Modell nicht in der Lage ist, den Kontext der Eingabe korrekt zu interpretieren, kann es zu einer unerwarteten Bedeutung des Wortes führen, was zu Halluzinationen oder Drift führen kann.

Um das Auftreten von Drift in LLMs zu minimieren, kann man versuchen, das Modell auf eine breite Palette von Kontexten und Situationen zu trainieren, in denen Wörter mit mehreren Bedeutungen auftreten. Durch die Erhöhung der Vielfalt der Trainingsdaten kann das Modell lernen, Kontexte besser zu verstehen und eine angemessenere Bedeutung des Wortes auszuwählen.

Hier wird auch klar, warum OpenAI, Google etc. versuchen immer grössere Modelle mit immer mehr Trainingsdaten zu füttern. Es steht jedoch nicht zu erwarten, dass letztendlich vollständige, zuverlässige Korrektheit erreicht werden kann. Dessen müssen wir uns immer bewußt sein, wenn wir mit LLMs und anderen Formen generativer AI arbeiten.

Zum jetzigen Zeitpunkt ist es völlig unverantwortlich, irgendwelche Entscheidungen von generativer AI und LLMs abhängig zu machen. In nächster Zukunft werden sie als Kreativwerkzeuge, zur Erzeugung von Marketing-Texten, für die "Normalisierung" von Texten etc. breite Verwendung finden, weil hier die Ansprüche an faktische Korrektheit, Wiederholbarkeit und Nachvollziehbarkeit eher eingeschränkt sind. Für alles andere muss ihre Verwendung reguliert werden. Im Umgang mit Unternehmen und Behörden muss das Recht Entscheidungen von einem kompetenten Menschen gefällt zu bekommen, der nicht nur nachplappert, was ihm ein Computer vorgibt, gesetzlich verankert werden.

PS: Wenn Sie mich beim Schreiben von Realitätsabzweig unterstützen möchten: Einfach hinter untigem Button eine Unterstützungs-Subscription abschliessen.

Bonus-Content: ChatGPT4 kann auch Fefe-Style, allerdings eher noch nicht ganz überzeugend:

LLMs und die Drift-Katastrophe: Wenn künstliche Intelligenz den Bach runtergeht

Liebe Leute, heute möchte ich euch von einem echten Schlamassel in der Welt der künstlichen Intelligenz berichten, bei dem euch vermutlich die Haare zu Berge stehen werden: das sogenannte "Driften" von Large Language Models (LLMs) wie OpenAIs GPT-4. Diese Textgenerierungs-Monster sind dazu da, menschenähnlichen Text zu erzeugen, aber verdammt nochmal, sie schaffen es, sich dabei komplett zu verzetteln.

Was heißt das eigentlich, dieses "Driften"? Im Klartext bedeutet das, dass diese künstlichen Intelligenzen vom eigentlichen Thema abkommen und völlig wirre, irrelevante oder sogar falsche Infos in ihren Texten raushauen. Warum passiert das? Na, weil sie auf riesigen Haufen von Daten trainiert werden, die nicht selten veraltet, voreingenommen oder einfach nur Schrott sind. Das Driften entsteht auch, weil das Training ein endloser Loop aus Fehlern ist, bei dem die Modelle ständig auf ihrem eigenen Mist aufbauen.

Aber wieso sollten wir uns überhaupt einen Kopf um das Driften von LLMs machen? Ganz einfach: Weil diese Dinger mittlerweile überall eingesetzt werden – bei Chatbots, Texterstellung, Übersetzungen und sogar in Nachrichtenartikeln.

Das Problem ist, dass wir diesen künstlichen Intelligenzen vertrauen, um uns präzise und korrekte Infos zu liefern. Aber wenn sie anfangen, Mist zu bauen, kann das dazu führen, dass wir komplett falsch informiert sind und Entscheidungen treffen, die uns um die Ohren fliegen. Stellt euch vor, das passiert bei politischen Entscheidungen oder medizinischen Ratschlägen – da geht's um die Wurst!

Die gute Nachricht ist, dass Forscher bereits fieberhaft daran arbeiten, den Schlamassel in den Griff zu bekommen. Ein Ansatz ist, LLMs ständig mit frischen, sauberen Daten zu füttern, um das Driften einzudämmen. Ein anderer Weg ist, Überwachungsmechanismen einzubauen, die den generierten Text in Echtzeit checken und falsche oder irreführende Inhalte erkennen und korrigieren.

Aber mal ehrlich: Es bleibt eine Mammutaufgabe, diese LLMs wirklich zu zähmen. Deshalb ist es wichtig, dass wir uns im Klaren sind, dass sie nicht perfekt sind und wir nicht einfach alles schlucken sollten, was sie uns vorsetzen. Informationen aus verschiedenen Quellen prüfen und den gesunden Menschenverstand einsetzen bleibt unerlässlich.

Bleibt kritisch und wachsam, Freunde. In einer Welt, in der künstliche Intelligenz immer mehr Einfluss auf unser Leben hat, müssen wir uns der Risiken und Fallstricke bewusst sein und darauf vorbereitet sein, angemessen darauf zu reagieren.