Warnung vor Betrug durch neue Gesichtsanimationstechnik

VASA-1: Wie lebensechte, audiogesteuerte Gesichter unsere Interaktion mit Technologie verändern könnten

Das Projekt VASA-1 wurde von einem Forschungsteam bei Microsoft Research entwickelt. Das Team unter der Leitung von Sicheng Xu und weiteren Forschern wie Guojun Chen, Yu-Xiao Guo, und anderen konzentriert sich darauf, lebensechte sprechende Gesichter zu erzeugen, die durch ein statisches Bild und einen Sprachaudio-Clip animiert werden. Sie haben Methoden entwickelt, die in Bezug auf die Videoqualität und den Realismus der Gesichtsdynamik gegenüber früheren Ansätzen erheblich verbessert wurden.

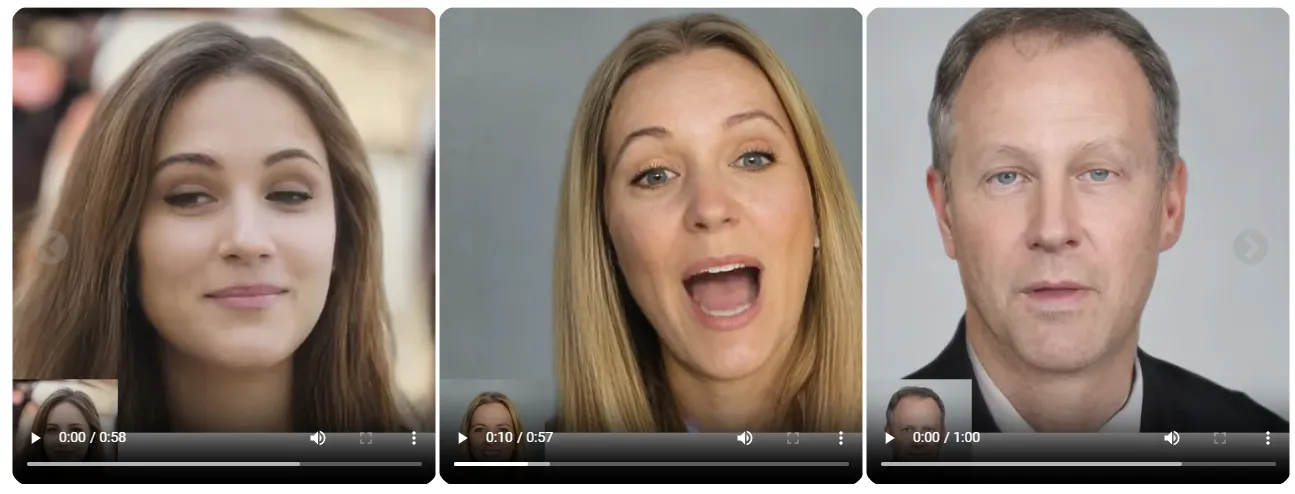

Hinweis: Alle Porträtbilder auf dieser Seite sind virtuelle, nicht existierende Identitäten, die mit StyleGAN2 oder DALL·E-3 generiert wurden (außer Mona Lisa). Das Forschungsteam erforscht visuell-affektive Fähigkeiten für virtuelle, interaktive Charaktere und beabsichtigen nicht, reale Personen nachzuahmen. Dies ist lediglich eine Forschungsdemonstration; es gibt keine Pläne zur Produkt- oder API-Veröffentlichung.

Aktuell gibt es laut den Entwicklern von VASA-1 keine Pläne zur Veröffentlichung eines Produkts oder einer API. Die Technologie wurde als Teil einer Forschungsdemonstration entwickelt, um die Möglichkeiten und das Potenzial in diesem Bereich aufzuzeigen, jedoch ohne konkrete Absicht zur kommerziellen Nutzung oder öffentlichen Verfügbarkeit in naher Zukunft.

VASA-1: Lifelike Audio-Driven Talking Faces Generated in Real Time

In einer Welt, in der digitale Kommunikation immer mehr an Bedeutung gewinnt, stellt die Forschungsarbeit "VASA-1: Lifelike Audio-Driven Talking Faces Generated in Real Time" einen bemerkenswerten Fortschritt dar. Dieses neue Framework, entwickelt von einem internationalen Forscherteam, ermöglicht die Erzeugung von realistischen sprechenden Gesichtern aus einem einzigen Foto und einem Audio-Clip. Diese Technologie könnte nicht nur die Art und Weise, wie wir mit Maschinen kommunizieren, revolutionieren, sondern auch weitreichende Anwendungen in der Bildung, im Gesundheitswesen und in der Unterhaltungsindustrie finden.

Die Technologie hinter VASA-1

Grundlagen und Funktionsweise

VASA-1 basiert auf einem diffusionsbasierten Modell, das Gesichtsdynamiken und Kopfbewegungen in einem sogenannten Gesichtslatenzraum erzeugt. Die Forscher haben ein System entwickelt, das durch die Analyse von Videos ein tiefes Verständnis für Gesichtsbewegungen erlangt. Dies ermöglicht es VASA-1, Lippenbewegungen synchron zum Audio zu generieren und gleichzeitig ein breites Spektrum an Gesichtsnuancen und natürlichen Kopfbewegungen darzustellen.

(Si apre in una nuova finestra)

(Si apre in una nuova finestra)Anwendungsgebiete

Ein zentrales Ziel von VASA-1 ist es, die digitale Kommunikation zu bereichern und zugänglicher zu machen. Vorstellbar wären Einsatzmöglichkeiten wie interaktives KI-Tutoring, das Schülern hilft, komplexe Themen besser zu verstehen, oder virtuelle Therapeuten, die in der Lage sind, auf die emotionalen Zustände ihrer menschlichen Gegenüber einzugehen.

Potenzielle Auswirkungen auf die Gesellschaft

Bildung

In der Bildung könnte VASA-1 Lehrkräfte unterstützen oder sogar teilweise ersetzen, insbesondere in Gebieten, wo qualifizierte Lehrer knapp sind. Durch realistische Avatare könnten Schüler eine persönlichere Bindung zum Lernmaterial aufbauen, was die Motivation und letztendlich die Lernerfolge verbessern könnte.

Gesundheitswesen

Im Gesundheitswesen könnten durch VASA-1 generierte Avatare Patienten begleiten und unterstützen. Sie könnten als virtuelle Begleiter dienen, die Patienten durch Therapiesitzungen führen oder als Ansprechpartner für ältere Menschen fungieren, die zusätzliche Gesellschaft benötigen.

Unterhaltungsindustrie

In der Unterhaltung könnte die Technologie dazu beitragen, realistischere und interaktive Charaktere zu schaffen. Videospiele und virtuelle Realität könnten so auf ein neues Level der Immersion gehoben werden.

Herausforderungen und ethische Überlegungen

Technische Herausforderungen

Die größte Herausforderung für die Entwickler von VASA-1 ist die Vermeidung von "Uncanny Valley"-Effekten, bei denen die Charaktere fast real erscheinen, aber dennoch subtile Unstimmigkeiten aufweisen, die Unbehagen hervorrufen können. Weiterhin muss die Technologie in Echtzeit funktionieren, um für interaktive Anwendungen geeignet zu sein.

Ethische Bedenken

Mit der Fähigkeit, überzeugende digitale Menschen zu erschaffen, kommt auch die Gefahr des Missbrauchs. Könnten solche Technologien verwendet werden, um Fake News oder gefälschte Videos zu erstellen? Die Entwickler haben klargestellt, dass sie intensiv daran arbeiten, solche Risiken zu minimieren und Methoden zur Erkennung von Fälschungen zu verbessern.

Risiken für Missbrauch durch Betrüger

Wir von Mimikama warnen eindringlich vor den Gefahren, die mit der öffentlichen Verfügbarkeit von Technologien wie VASA-1 verbunden sind. Diese fortschrittlichen Gesichtsanimations-Tools könnten Betrügern die Möglichkeit bieten, täuschend echte Fake-Videos zu erstellen.

Stellen Sie sich vor, jemand verwendet ein Facebook-Profilbild und einen zufälligen Audio-Clip, um ein Video zu erzeugen, das zeigt, wie eine real existierende Person etwas sagt oder tut, was nie passiert ist.

Solche Videos könnten in betrügerischen Szenarien eingesetzt werden, um die Reputation zu schädigen, falsche Beweise zu schaffen oder Menschen in Online-Betrügereien zu locken.

Unsere Mission ist es, auf diese Risiken aufmerksam zu machen und die Öffentlichkeit über potenzielle Missbrauchsmethoden zu informieren, damit vorbeugende Maßnahmen ergriffen werden können.

Werde auch Du ein Mimikama-Botschafter, solltest Du noch keiner sein!

Mimikama ist entscheidend im Kampf gegen Falschinformationen, die unsere Demokratie gefährden. Ihre Faktenchecks benötigen jedoch finanzielle Mittel. Durch Ihre Unterstützung kann Mimikama weiterhin wertvolle Aufklärungsarbeit leisten und die Integrität unserer öffentlichen Diskussionen bewahren. Jeder Beitrag zählt.

Wer nicht regelmäßig beitragen möchte, kann Mimikama auch einmalig unterstützen – beispielsweise mit dem Betrag für einen Kaffee via PayPal.