The Ethics of Synthetic Voices from beyond the grave

Ich schiebe diese Story schon eine Weile vor mir her, 1. aus dem banalen Grund, dass den verstorbenen TV-Koch und die Doku hierzulande keiner kennt und 2. weil ich zum Thema mehr als ein Schulterzucken mit einem geraunten “Told you so” nicht viel sagen kann. Es ist so.

In Amerika erschien jüngst eine Dokumentation, in der der verstorbene Fernseh-Koch Anthony Burdain Zitate aus seinen Emails vorlas. Außer, dass der Verstorbene nun verstorben ist und Verstorbene keine Emails vorlesen können, die Stimme also eine synthetisch erzeugte AI-Stimme war. Die Aufregung ist nun einigermaßen groß, hier exemplarisch der Artikel im New Yorker: The Ethics of a Deefake Anthony Bourdain Voice (S'ouvre dans une nouvelle fenêtre). Die Meinungen reichen von “Ein Betrug am Zuschauer und eine pietätlose Respektlosigkeit gegenüber Verstorbenen” bis hin zu “der durchaus dramatisch-narrativ denkende Herr wäre stolz auf diese Leistung der Postmoderne und auf diesen Meilenstein für Fiktionalisierungstechniken dokumentarischer Inhalte.”

Ich persönlich tendiere zu letzterem, kenne den Herrn aber nicht und gebe zu, dass eine AI-Stimme für einen Verstorbenen in einer Doku durchaus Fragen aufwirft, die etwa eine Leia in Space für eine verstorbene Carrie Fisher nicht aufwirft. Aber!

AI-Technologien und Computer-Vision haben in den letzten Jahren eine rasante Entwicklung hingelegt und die (auch AI-gestützte) Manipulation von Bildmaterial ist jedem Kind bekannt und sei es nur durch banale Instagram-Filter. Diese Technologien verursachen bereits jetzt für Verzerrungen des psychologischen Selbst-Bildes, das Phänomen nannte man zuerst Snapchat-Dysmorphia, zuletzt Zoom Dysmorphia (S'ouvre dans une nouvelle fenêtre). Ich möchte an dieser Stelle nicht näher auf diese Phänomene selbst eingehen, mir geht es an dieser Stelle alleine um die Fusion des Digitalen Raums mit dem Raum der Selbstwahrnehmung.

Ich kann daher sehr gut nachvollziehen, wenn man diesen speziellen Deepfake als extrem unethisch, als Betrug am Zuschauer und als pietätlose Respektlosigkeit wahrnimmt. Die Realitätverzerrung des algorithmischen Deepfakes kollidiert mit voller Wucht mit der Semi-Authentizität des Dokumentarischen einerseits, mit der brutalen Realität des Todes andererseits. Das schafft ein besonderes Spannungsverhältnis, das die Eskalation der Debatte während dieses speziellen Deefakes erklärt, obwohl weder die Technologie noch ihre Möglichkeiten noch ihre Anwendung neu sind (ich erinnere an die synthetisch generierte Jordan Peterson-Stimme vor ein paar Jahren).

Der Fall ist für mich selbst recht unspektakulär, es ist ein weiterer Schritt in eine Zukunft, in der Realität und unsere Wahrnehmung derselben dank digitaler Technologie editierbar wird und der Digitale Raum die Erfüllung postmoderner Philosophie bedeutet. Der Deepfake von Burdains Stimme bedeutet wortwörtlich, aber vor allem im sprichwörtlichen Sinne der Einbruch von Freuds Unheimlichen in den Diskurs um das Digital. Die Absenz des Heimeligen, also dem Bekannten, Wohligen, Vertrauten, hier die bekannte Stimme aus dem Fernsehen, digital ver-unheimlicht durch die Kollision des Digitalen Edits mit der Wirklichkeit des Todes.

Die neue digital erzeuge Realität der Postmoderne, in der die Bestandteile aller Eindrücke zum Ausdrucksmittel werden und endlos neu zusammengesetzt werden können, auch Remix-Culture genannt, ist ein endloser Taumel zwischen Realitätsverlust und Wirklichkeit im Uncanny Valley, in der “nichts wahr ist und alles möglich” (Peter Pomerantsev).

Es gilt weiterhin: “Kiss your reality goodbye” und “Welcome to the Future”.

Holly+ 👭🗣️🦾

Interessantes Konzept, möglicherweise der erste Cryptobullshit, der tatsächlich bedenkenswerte Fragen aufwirft. Meines Erachtens ergibt die Blockchain und Crypto als Kunstwerk ohnehin sehr viel mehr Sinn, denn als seriöse Technolgie für Verträge und Währungen. Jedenfalls, Holly Herndon (S'ouvre dans une nouvelle fenêtre) synthetisiert ihre Stimme und verkauft Besitzanteile als NFT, das Gesamtkonzept inklusive synthetischer Stimme ist ein sogenanntes DAO, eine Decentralized Anonymous Organization (S'ouvre dans une nouvelle fenêtre), deren Einkünfte aus Popsongs die Erzeugung neuer Tools rund um die Stimme der Künstlerin finanzieren sollen.

I am releasing Holly+ (S'ouvre dans une nouvelle fenêtre) in collaboration with Never Before Heard Sounds (S'ouvre dans une nouvelle fenêtre), the first tool of many to allow for others to make artwork with my voice, and will distribute ownership of my digital likeness through the creation of the Holly+ DAO 👭 My voice is precious to me! It is 1 of 1 🥰 Voice Models, in combination with machine learning technology, already allow for anyone to clone a voice to generate music and media, and the opportunities and complications inherent to these techniques will only intensify! This development raises novel questions about voice ownership that I think can be addressed by DAO governance 🤝 I plan to decentralize access, decision making and profits made from my digital twin, Holly+ 👭 Profits made from the commercial usage of my digital likeness will be ingested by the DAO, who are able to vote on new tool creation, and approve official usage of my twin, Holly+ 🧞♀️ I will soon be launching a Zora auction house to sell approved works made with my likeness 👩⚖️ (…)

While a public figure is protected from unlicensed commercial exploitation of their vocal likeness, there are also great benefits to offering the public open source access to a voice model under a GNU General Public License (S'ouvre dans une nouvelle fenêtre). This license ensures that all derivative works created through experimentation in the voice would also be open source and not commercially exploitable 👩🏫

Through providing artists and researchers access to the voice under these terms, it increases the likelihood of the voice’s prominence online, which in turn only contributes to the value of the original voice model itself.

This approach supports the “My Collectible Ass” principle, advocated for by ZORA (S'ouvre dans une nouvelle fenêtre) and originally proposed by theorist McKenzie Wark (S'ouvre dans une nouvelle fenêtre). This principle states that the more prominent and visible/audible a work of art is, the more valuable the certified original becomes.

Images generated by AI Machine

Ich habe neulich schon ein paar meiner Favs aus dem "Images Generated By AI Machines (S'ouvre dans une nouvelle fenêtre)"-Tweetiefeed auf Facebook gepostet (S'ouvre dans une nouvelle fenêtre), hier nochmal ein paar davon. Mighty out there.

“Heat Death of the Universe”

One of my AI-petpeeve-theories is the audiovisual wishfulfillmentmachine, in which you tell Alexa what kind of movie you wanna see and then you just get what you wish for: "Alexa, give me Avengers in the Style of David Lynch but with black and asian actors only" and voilá, you get Asianblack-Avengers, served.

This goofing around with AI is the embrionic state of this tech.

I totally wanna party at this cyberpunk rave and eat a vibrant dog torus there.

“Cyberpunk Rave”

“Dracula on a beach in hawaii”

“Vibrant Dog Torus”

Falls Ihr ebenfalls solche AI-Pics generieren wollt, hier ein Tutorial auf Google Docs (S'ouvre dans une nouvelle fenêtre), no coding skills required. (Das erste im Tutorial verlinkte Google Colab scheint buggy und funktioniert bei mir nicht, das zweite aber sehr wohl.)

Man wählt die zu ladenden Bild-Datenbanken aus und führt die einzelnen Felder in Google Colab separat aus mit einem Klick auf das Run-Zeichen links, schließlich im vorgesehenen Feld die Wortkombo eingeben, die generiert werden soll und ab geht die Luzie. Ich arbeite hier unter erschwerten Produktionsbedingungen, aber kann schonmal eine Bilderserie von AI-Blackmetal-Alben ankündigen weil SATAN NEVER DIES!

Bessere Ergebnisse erzeugt man mit dem “Unreal Engine Trick (S'ouvre dans une nouvelle fenêtre)”, bei dem man der Wortkombination das Keyword “Unreal Engine” hinzufügt. Funktioniert auch mit etwa “dramatic light” oder “render”/“render glas texture”. Diese Art der Wortfindung ist genau, was oben weiter unten unter dem Stichwort “Neuroaesthetics” als “Fusion von Mensch und Maschine” angesprochen wurde: “VQGAN+CLIP makes you think like machine render wood texture on fire.jpg”

Charlie Snell hat einen schönen Artikel über die “Kunst-Szene”, die sich um die Erzeugung von Bildern mit diesen speziellen AI-Tools VQGAN+CLIP gebildet hat: Alien Dreams: An Emerging Art Scene (S'ouvre dans une nouvelle fenêtre). Ich bin mit dem Wort “Kunst” etwas vorsichtiger und würde diese Gemeinschaft aus Leuten nicht unbedingt als Künstler, sondern eher als Entdecker des Latent Space von AI-Modellen nennen wollen, was der Faszination dieser Bilder der neuen Maschinenbewusstseins aber keinen Abbruch tun soll.

Ever since OpenAI released the weights and code for their CLIP model, various hackers, artists, researchers, and deep learning enthusiasts have figured out how to utilize CLIP as a an effective “natural language steering wheel” for various generative models, allowing artists to create all sorts of interesting visual art merely by inputting some text – a caption, a poem, a lyric, a word – to one of these models. (…)

Since the CLIP based approach is a little more hacky, the outputs are not quite as high quality and precise as what’s been demonstrated with DALL-E. Instead, the images produced by these systems are weird, trippy, and abstract. The outputs are grounded in our world for sure, but it’s like they were produced by an alien that sees things a little bit differently.

It’s exactly the weirdness that makes these CLIP based works so uniquely artistic and beautiful to me. There’s something special about seeing an alien perspective on something familiar.

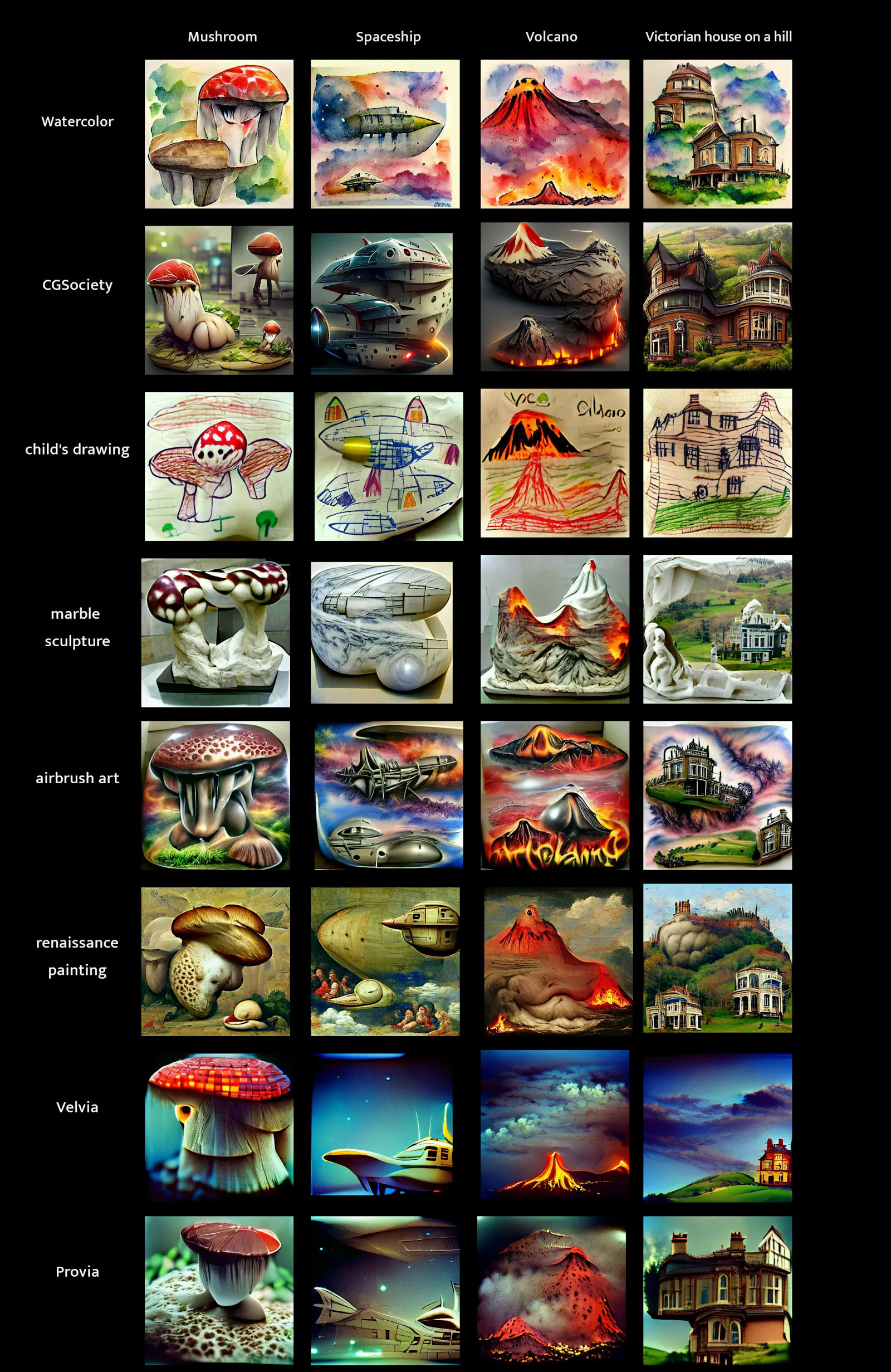

CLIP + VQGAN keyword comparison

Schöne Übersicht über die verschiedenen ästhetischen Vektoren von VQGAN+CLIP (S'ouvre dans une nouvelle fenêtre). Das Neural Net erzeugt Vulkane, Raumschiffe, Pilze und ein “viktorianisches Haus auf einem Hügel”, kombiniert mit verschiedenen Keywords wie “pencil sketch” oder “PS2 Graphics” oder “Bryce 3D” oder “Criterion Collection”.

N E U R O A E S T H E T I C S

Erik Morse im Artforum über Neuroaesthetics (S'ouvre dans une nouvelle fenêtre), meines Erachtens eine sehr gute Deutung von AI-Kunst als ästhetischer Ausdruck der “Idea of becoming brain”. Wenn wir Wortkombinationen in Bildgeneratoren wie VQGAN+CLIP (S'ouvre dans une nouvelle fenêtre) eingeben, fusionieren wir mit den Prozessen einer Künstlichen Intelligenz, wir passen unsere Wortwahl diesen Prozessen entsprechend an und das ästhetische Ergebnis ist Ausdruck dieser Gehirn-Fusion. Neuroaesthetics. I like.

Warren Neidich, an artist (…) and a former physician, had coined the term [Neuroaesthetics] in a series of lectures at SVA in the mid-1990s to describe the acceleration in information technologies that had consumed our daily lives and its effects on the development of the brain. For Neidich, post-studio art—with its interest in appropriation, contextualism, and semiotic drift—was uniquely suited to the task of comprehending these effects.“

Neuroaesthetics can perhaps be understood in the Duchampian sense,” he claimed in a 2004 interview. “Neuroscience is a readymade, which is recontextualized out from its original context as a scientific-based paradigm into one that is aesthetically based.” He pointed to Conceptualists like Dan Graham and Sol LeWitt as precursors of a later generation of artists who would act as mediators between an increasingly technologized and monetized society and its hyperactive visual culture. Neuroaesthetics endeavored not to produce a synthesis of neuroscience and aesthetics, but rather to estrange the former from normal usage—much as Duchamp did the bicycle wheel and bottle rack—and reenvision in a more psychodynamic capacity its tools for mapping cognitive categories such as color, memory, and spatial relationships, in order to reveal, in Neidich’s words, “the idea of becoming brain.”

AI Desperately Attempts to Create Ace Attorney Case and actually does Okay (S'ouvre dans une nouvelle fenêtre)

https://www.youtube.com/watch?v=Do1fN_isFx8 (S'ouvre dans une nouvelle fenêtre)New Algorithm Flies Drones Faster than Human Racing Pilots

I for one welcome my new Drone Racing AI-Overlords (S'ouvre dans une nouvelle fenêtre):

For the first time an autonomously flying quadrotor has outperformed two human pilots in a drone race. The success is based on a novel algorithm that was developed by researchers of the University of Zurich. It calculates time-optimal trajectories that fully consider the drones’ limitations.

At The End

Some rather meaningless AI-Toys all kinda outofdate, but fun nevertheless with appropriate URL: Bored Humans (S'ouvre dans une nouvelle fenêtre).

AI Paintings (S'ouvre dans une nouvelle fenêtre) - Our AI creates art.

This Pizza Does Not Exist (S'ouvre dans une nouvelle fenêtre) - Generated by a computer.

Falling Sand (S'ouvre dans une nouvelle fenêtre) - Play with lava, water, napalm and more.

Photo Blender (S'ouvre dans une nouvelle fenêtre) - Two beautiful photos combined into one.

TV Episode Generator (S'ouvre dans une nouvelle fenêtre) - Game of Thrones, The Simpsons, Friends, and more.

Story Generator (S'ouvre dans une nouvelle fenêtre) - Our AI will tell you a story.

AI Colorized Movies (S'ouvre dans une nouvelle fenêtre) - Watch classic films for free.

New Words (S'ouvre dans une nouvelle fenêtre) - These words do not exist.

Photo Search (S'ouvre dans une nouvelle fenêtre) - AI detects what is in each photo.

Heavy Metal Lyrics Generator (S'ouvre dans une nouvelle fenêtre) - Our AI rocks!

Subscribe to GOOD INTERNET on Substack (S'ouvre dans une nouvelle fenêtre) or on Patreon (S'ouvre dans une nouvelle fenêtre) or on Steady (S'ouvre dans une nouvelle fenêtre) and feel free to leave a buck or two. If you don’t want to subscribe to anything but want to send a pizza or two, you can paypal me (S'ouvre dans une nouvelle fenêtre).

You can also buy Shirts and Stickers (S'ouvre dans une nouvelle fenêtre) like a real person.

Thanks.